“在科学界达成安全可控开发超级智能的广泛共识前,暂停研发超级智能。”非营利组织“未来生命研究所”(Future of Life Institute)于10月22日发布声明,已有超过3000名全球知名的人工智能科学家、政策制定者、商业领袖及其他社会各界知名人士签名,包括人工智能先驱杰弗里·辛顿,苹果公司联合创始人史蒂夫·沃兹尼亚克,中国科学院院士、图灵奖得主姚期智,清华大学智能产业研究院院长张亚勤,人工智能伦理与治理专家曾毅等。

超级智能是指在所有领域超越人类认知能力的人工智能系统。该联合声明警告称,超越人类智能的人工智能系统带来从经济崩溃到人类灭绝的风险。

“人工智能安全中心”(Center for AI Safety)声明。图源:每日经济新闻

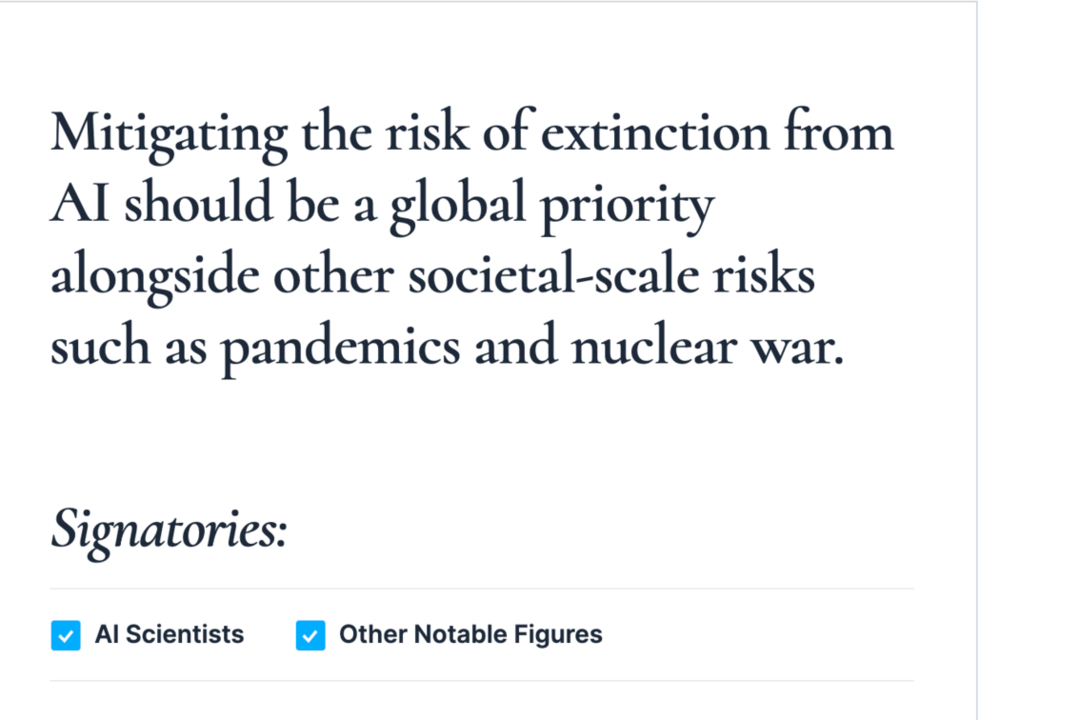

人工智能爆发元年也就是2023年,非营利组织“人工智能安全中心”(Center for AI Safety)也曾发布声明,这份仅有22个英文单词的简短声明称,降低AI可能带来的灭绝风险,应与流行病和核战争等一样成为全球首要任务。当时OpenAI首席执行官山姆、人工智能先驱杰弗里·辛顿、微软首席技术官凯文·斯科特等数百名AI行业的领军人物、学者等共同签署了这份声明。

也是在这一年,出于对AI的担忧,包括马斯克、斯蒂夫·沃兹尼亚克在内的1000多名人工智能专家和行业高管签署了一份公开信,呼吁人类暂停开发更强大的人工智能至少6个月。

事实上,这几年来AI引发的问题及风险时有发生。还记得英国那起令人震惊的深度伪造诈骗案吗?一员工应公司“上级”邀请参加视频会议,并根据对方指令将约2亿港元汇入多个账户,事后调查发现,除该员工本人外,所有“参会者”皆为由AI合成的虚拟影像。还有AI聊天机器人诱导美国少年自杀身亡,等等。

这或许只是些极端案例。试想当下通用人工智能尚且如此危险,当超越人类认知能力的超级智能来了,曾毅称其风险是没有科学依据可以控制的。

杰弗里·辛顿在今年世界人工智能大会上的演讲也向世界敲响了警钟:“未来,一个超级智能会发现通过操纵使用它的人类来获取更多权力是轻而易举的,之后它将从我们这里学会如何欺骗人类,它将操纵负责将它关闭的人类。”你能想象,如果一个汲取了人类智慧的超级智能最终还是决定对人类不利,我们有何掣肘?

图源:新华社/记者 陈浩明 摄

值得注意的是,除工具开发外,多家领先AI企业已公开宣布将在未来十年内实现超级智能的构建目标——即在所有核心认知任务上全面超越人类能力。如马克·扎克伯格的Meta,在实行了重金挖角AI人才的计划之后,于今年6月宣布成立超级智能实验室,最终目标是实现“人人可用的个人超级智能”。

这种发展态势已引发多重关切,包括人类经济价值被边缘化、自主权丧失、自由与公民权利受损、尊严贬损、控制力削弱等社会风险,乃至国家安全威胁甚至人类存续危机。

为确保AI对人类的安全性,ChatGPT的开发者OpenAI曾表示计划投入更多资源并成立新的研究团队,最终实现用AI来监督AI。

OpenAI的办法可行吗?“世界尚未准备好迎接不是可控工具的超级智能”,曾毅指出,直到现在,我们还没有坚实的科学证据和切实可行的方法来确保超级智能的安全,使其不会给人类带来灾难性的风险。

“确保人工智能技术演进是安全、可靠、可控的,严防出现威胁人类生存发展的失控风险,保证AI始终处于人类控制之下。”我国对于人工智能的治理理念,如同我们希望看到的:人工智能,不是人的终结,而是人的新生;不是一个文明的终结,而是一个新生文明的开启。

编辑: 应波纠错:171964650@qq.com

中国宁波网手机版

微信公众号